Lesen, Hören, Gucken, Schreiben

(c) Zonix 2005

Was?

Inkohärentes Geschreibsel eines Late Adopters

Ralph

E-Mail oder kontaktiert range im IRCNet oder auf Freenode.

Bilder

Ralphs Bildergalerie

Feed Me!

Hier gibt es einen RSS-Feed. Oder folgt mir bei Twitter.

| Februar 2015 | ||||||

|---|---|---|---|---|---|---|

| So | Mo | Di | Mi | Do | Fr | Sa |

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Einträge nach Datum:

- Januar 2012 (1)

- Oktober 2010 (1)

- Maerz 2010 (1)

- Oktober 2009 (1)

- September 2009 (1)

- Juli 2009 (3)

- Juni 2009 (3)

- Mai 2009 (1)

- April 2009 (1)

- Maerz 2009 (4)

- Januar 2009 (2)

- Dezember 2008 (3)

- November 2008 (1)

- Oktober 2008 (2)

- September 2008 (2)

- August 2008 (3)

- Juli 2008 (2)

- Juni 2008 (5)

- Mai 2008 (2)

- April 2008 (9)

- Maerz 2008 (2)

- Februar 2008 (2)

- Januar 2008 (4)

- Dezember 2007 (2)

- November 2007 (6)

- Oktober 2007 (5)

- September 2007 (13)

- August 2007 (8)

- Juli 2007 (4)

- Juni 2007 (5)

- Mai 2007 (7)

- April 2007 (8)

- Maerz 2007 (9)

- Februar 2007 (3)

- Januar 2007 (5)

- Dezember 2006 (1)

- November 2006 (4)

- Oktober 2006 (1)

- September 2006 (2)

- August 2006 (6)

- Juli 2006 (7)

- Juni 2006 (8)

- Mai 2006 (10)

- April 2006 (11)

- Maerz 2006 (19)

- Februar 2006 (14)

- Januar 2006 (13)

- Dezember 2005 (15)

- November 2005 (18)

Kategorien:

- administriva - 6

- bücher - 1

- centos - 25

- computer - 26

- design - 1

- freesoftware - 2

- hardware - 4

- internet - 11

- linux - 3

- mail - 2

- filme - 3

- fotos - 6

- kram - 42

- sprache - 6

- lifestyle - 13

- medien - 10

- musik - 29

- hören - 8

- konzerte - 8

- politik - 32

- tv - 6

- ueberraschung - 19

- unmut - 33

- verkehr - 9

Auch lesbar

Na, einfach shrek[]

Sieh die Welt mit meinen Augen

Das Schwätzbrett

Das Bildblog

D'ohne Pointe

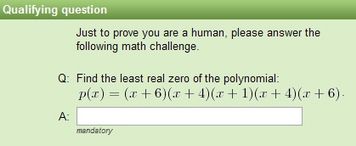

Captchas riechen nicht mehr komisch, sie sind tot

2008-08-30Captchas (Completely Automated Public Turing test to tell Computers and Humans Apart) sind diese kleinen schlecht lesbaren Bildchen auf denen nicht erkennbare Buchstaben und Zahlen abgelesen werden müssen und dann in ein Textfeld eingegeben werden sollen. Damit ist es angeblich möglich, Computer und Menschen auseinanderzuhalten, da nur Menschen in der Lage sein sollen, diese Bilderrätsel zu lösen. Habe ich in diesem Artikel ein System vorgestellt, welches Captchas vollautomatisch löst — und dabei Captchas erkennt, an denen ich regelmäßig scheitere — ist die “menschliche” Erkennungsrate wohl doch noch höher.

Diese Captchas sollen mittlerweile nicht mehr nur vor Spam schützen — hier vor allem in Webforen oder auf Wikis — sondern auch Banken oder Webmailer wie Googles gmail.com setzen auf diese Methode, um automatisiertes Anlegen von Accounts zu erschweren oder um dem Kunden einen angeblichen weiteren Schutz beim Onlinebanking zu geben. Kein Wunder, dass es immer mehr Menschen gibt, die Interesse daran haben, solche Captchas generell lösen zu können — natürlich nicht immer für lautere Zwecke.

Diese Captchas sollen mittlerweile nicht mehr nur vor Spam schützen — hier vor allem in Webforen oder auf Wikis — sondern auch Banken oder Webmailer wie Googles gmail.com setzen auf diese Methode, um automatisiertes Anlegen von Accounts zu erschweren oder um dem Kunden einen angeblichen weiteren Schutz beim Onlinebanking zu geben. Kein Wunder, dass es immer mehr Menschen gibt, die Interesse daran haben, solche Captchas generell lösen zu können — natürlich nicht immer für lautere Zwecke.

Auftritt Indien: Dort hat sich “Captcha Solving” zu einer mittelgroßen Industrie gemausert. Firmen, die versprechen, 800 Captchas pro Stunde zu lösen, Datentypisten, denen US-$ 2,- pro 1000 gelösten Captchas gezahlt — alles natürlich unter dem Anschein der Legalität: “Wir lösen Captchas für sehbehinderte Personen, ermöglichen Wissenschaftlern die GMAIL-Captchas für ihr Projekt zu lösen”, aber in Wirklichkeit wird das natürlich alles für das organisierte Verbrechen genutzt.

Dancho Danchev hat in seinem Blog bei ZDNet einen erschreckenden Artikel zu dem Thema geschrieben. Man kann mit Gewißheit sagen: Captchas sind tot. Zumindest dann, wenn damit etwas von Wert geschützt werden soll. Und das im großen Stil. Wieder ein Sieg für das Verbrechen, wieder ein Verlust für die, die das Web nutzen wollen für Diskussionsforen, Wikis, Bugtrackingsysteme usw. — also alle Systeme, die davon leben, dass Menschen “von außen” leicht Kommentare oder Texte hinterlassen können.

Geschrieben um 18:24

[/computer/internet] [permanent link] [Startseite]

Spam in Webforen

2007-07-25Sie sind die Furunkel am schmutzigen Arsch des Internet: Spammer, die jegliches Kommunikationsmedium im Internet mit ihrer Werbung zumüllen. Sei es Mail, Usenet, Wikis, Blogs oder Webforen - kein Medium ist vor ihnen sicher. Nehmen wir mal Webforen als Beispiel: Wer hat sich bisher nicht gefragt, wie Spammer hunderte von Foren mit ihrem Müll verpesten?

Die Blogger der Securityfirma Pandasoftware haben jetzt ein Tool entdeckt, was diese Einträge automatisiert vornimmt — oder habt ihr etwa gedacht, dass Spammer “zu Fuß” von Forum zu Forum hoppeln? Das ist eine sehr beeindruckende Software, die in zwei Teilen kommt: Hrefer durchgräbt Suchmaschinen nach Webforen und sammelt diese Links. XRumer nimmt diese Links dann entgegen und verbreitet Werbedreck in den Webforen.

Und zwar vollautomatisiert: Wird ein Webforum entdeckt, legt die Software einen User an, wartet auf den “Activiation Link”, der normalerweise per Mail zugeschickt wird, aktiviert den Account und posted dann die Werbung in das Forum.

Aber dagegen kann man sich ja mit einem Captcha schützen — diesen unleserlichen Zeichenketten, mit denen man beweisen kann, dass man ein Mensch ist, da eine Maschine diese unmöglich entziffern kann, oder? Falsch. XRumer ist in der Lage eine ganze Reihe solcher Captchas zu identifizieren und auszulesen — sogar drei Versionen, an denen ich z.B. regelmäßig scheitere. Die Liste findet sich unten im Blogeintrag.

Um den Eintrag abzurunden gibt es auch ein Video, welches die Software in Aktion zeigt. Sehr beeindruckend, aber auch sehr sehr beängstigend, mit welch geringem Einsatz so ein Müll verbreitet werden kann.

Stirb Spammer, stirb

Geschrieben um 12:44

[/computer/internet] [permanent link] [Startseite]

Sowas von gar nicht Web-2.0

2006-08-25Tja. Leider verloren. Blogs sind also kein Web-2.0. Aber so richtig überhaupt nicht: “The score for http://lestighaniker.de/ is 4 out of 52” — damit kann man heute keinen Venture-Kapitalisten mehr aus dem wohlverdienten Bürofschlaf reißen. Aber andere sind ja auch nicht besser:

- The score for http://www.amazon.de is 3 out of 52

- The score for http://www.spiegel.de is 7 out of 52

- The score for http://www.oreilly.com is 11 out of 51 - immerhin, hat dort doch der ganze Hype angefangen

- The score for http://www.google.com is 2 out of 52

- usw.

Wer also ist dann Web-2.0, wenn schon das W3C nur 7 Punkte bekommt? Wenn Flickr nur 4 Punkte bekommt? Und auch Google Maps mit 6 Punkten nur wenig besser ist? Muss es Beta sein? Fehlen tag clouds? Sind Ruby on Rails oder Ajax oder Python notwendig? Muss man verstanden haben, was das Semantic Web ist? Runde Ecken? Nitro? MonoRail? Podcasting?

Egal, jetzt gibt es Abhilfe. Der Web-2.0 Validator hilft einem dabei, seine Seite für Web-2.0 zu rüsten. Soll ja keiner sagen können, er habe nicht gewusst, worauf es ankommt.

Update: Immerhin schon 14 von 52 möglichen Punkten. Da muss sich doch noch mehr rausholen lassen …

Geschrieben um 17:36

[/computer/internet] [permanent link] [Startseite]

Live: Tour de France mit Hilfe von Google Maps schauen

2006-07-05Nettes Mashup für alle, die im Büro keine Tour-de-France-Berichterstattung sehen oder hören können und denen ein Live-Ticker nicht genügt, da die geografischen Grundlagen fehlen: Tour de France via Google Maps anschauen.

Da nur die ersten 8 Fahrer berücksichtigt werden, lohnt aber ein Live-Ticker als Zusatzinformation, z.B. der der ARD

Geschrieben um 15:45

[/computer/internet] [permanent link] [Startseite]

Google Earth jetzt auch für Linux

2006-06-13Nachdem Google letztlich eine via wine “portierte” Version von Picasa herausgebracht hat, scheint es seit kurzer Zeit eine Linuxversion Google Earth zu geben. i386 only, natürlich nur ein Binary und keine Sourcen - aber immerhin eine native Version, auf Basis von Trolltechs QT. Downloadbar hier. Erstes Spielereien zeigen keine Probleme, das sieht wirklich nett aus. Braucht natürlich einen Computer mit Bums und einer vernünftigen 3D-Grafikkarte. Aber auf einem Thinkpad T40 mit 1,7GHz Centrino und einer ATI Radeon 9200 tut es immerhin.

Hier wohne ich (östlich neben dem runden Dach des lustigen Gebäudes), das Bild müsste von 2004 sein:

Geschrieben um 00:27

[/computer/internet] [permanent link] [Startseite]

Da draußen gibt es nur Idioten

2006-03-29Irgendwo in Russland, irgendwann im Dezember 2003, wurde in einem Forum eine Liste von “gehackten Webservern” gepostet. Dieses Forum lief unter thttpd, einem kleinen, leichtgewichtigen, schnellen Webserver für Unix. Und wie so oft weist man als Websitebetreiber auf die Software hin, die die Seite antreibt. Ein Klick also auf den Link, ein bisschen herumschnippeln am URL und man ist auf der Seite eines “Mitschuldigen am Webserverhack”.

Letzteres bildet man sich natürlich nur ein, wenn man zu dumm ist um sich frei im Internet bewegen zu dürfen. Und was für Vollidioten auf diese tolle Idee kamen, lässt sich am besten bei Jef Poskanzer selbst nachlesen. “these two investigative savants” beschreibt es eigentlich recht gut, wären da nicht diese indirekten Drohungen.

Manchmal fragt man sich, wie solche Leute es schaffen, gleichzeitig zu atmen und sich die Schuhe zuzubinden. Aber eventuell können sie ja selbst das nicht.

Geschrieben um 00:47

[/computer/internet] [permanent link] [Startseite]

Spam als Dienst am Kunden

2006-02-06Bei dem Googlespam, der zur Auslistung von BMW aus dem Suchindex von Google geführt hat, handelte es sich nicht um “Manipulation von Seiten, sondern um einen Dienst am Kunden”. Man wollte halt dass Kunden, die nach BMW suchen, auf den eigenen Seiten landen - und nicht auf denen von Fremdanbietern. Klar, schließlich ist BMW ja eigentlich der einzige Laden, der die hauseigenen Wagen anbietet.

Auch wenn es wirklich nur weniger als ein Prozent der Kunden ist, die über die Suchmaschine zu BMW kommen, so ist das doch ein bisschen frech (abgesehen davon, dass das eine Prozent absolut gesehen wohl doch eine etwas größere Zahl sein dürfte). Erstens ist Googlespam eine der nervigeren Möglichkeiten, Suchergebnisse bei Google wertlos zu machen. Zweitens: Wenn eure Seite von Google und anderen Suchmaschinen nicht erkannt wird - das erkauft man sich halt mit javascriptverseuchten Flashorgien: Sie sind angenehm für das Auge (ja, das ist Ansichtssache), sind aber leider sehr hinderlich, wenn man Informationen extrahieren will.

Und drittens: Wenn man bei etwas erwischt wird, was einem selbst unangenehm ist — Man darf auch mal sagen, dass man Mist gebaut hat. Bei den meisten Leuten die ich kenne, steigt man dadurch sogar im Ansehen, wenn man das offen zugibt. Durch Rechtfertigungen wie “Man würde ja nur im Dienste des Kunden handeln” tut man das eher nicht. Danke, aber ich bin mündig genug um selbst zu entscheiden, was Dienst an mir ist. Und was nicht.

Geschrieben um 16:54

[/computer/internet] [permanent link] [Startseite]

BMW: Sie sind raus!

2006-02-05Google wirft BMW aus dem Suchindex. BMW hat zu viele “Doorway Pages” benutzt, die der Suchmaschine einen anderen Inhalt vorgaukelten als den, den der Suchende sah. Dieser wurde nämlich mit einem Javascript-Redirect auf eine völlig andere Seite weitergeleitet. Laut Matt Cutts wird ricoh.de demnächst aus ähnlichen Gründen aus dem Suchindex fliegen.

Sehr schön. Erstens zeigt das, dass Google tatsächlich etwas gegen den Suchmaschinenspam macht. Jeder, der schon einmal versucht hat z.B. einen Testbericht zu einem elektronischen Gerät bei Google zu finden, sieht sich schließlich nach ein paar Versuchen mit einem Suchbegriff konfrontiert, der zumindest “-ebay -auktion -amazon -preisvergleich” enthält.

Zweitens wird hier tatsächlich auch mal einem Großen an den Karren gepisst. Wenn man sich anschaut, wie sich die Hersteller von Antivirenprogrammen geziert haben, das auf den Sony-CDs vorhandene Rootkit in ihre Signaturdatenbanken aufzunehmen. Weiter so.

Dennoch hält sich meine Hoffnung, doch mal wieder eine verwendbare Suchmaschine zu bekommen, in Grenzen.

Geschrieben um 13:20

[/computer/internet] [permanent link] [Startseite]

And it becomes besser

2005-12-12“And in order ton your remaining customers, you luggage on the vergraulen thus quietly remaining album A CoPy protection drauf” - mal gucken, wie oft man das “übersetzen” kann, bis irgendwas neues draus wird.

Geschrieben um 14:30

[/computer/internet] [permanent link] [Startseite]

Dank you, Google

2005-12-12Gerade mal geguckt, ob und wie das Blog hier gefunden wird. Und dann aus Neugier mal auf den “Translate”-Link geklickt. Ich hätte es nicht schöner ausdrücken können.

And in order to also still vergraulen your remaining customers, you pack on the remaining albums a copy protection drauf

Geschrieben um 14:27

This work is licensed under a Creative Commons Attribution-Noncommercial-Share Alike 2.0 Germany License.